La tecnología a favor de la accesibilidad de todas las personas. Este es uno de los principales objetivos de todos los ingenieros informáticos que se ponen al servicio de aquellos que tienen algún tipo de discapacidad a la hora de crear nuevos dispositivos que mejoren su calidad de vida. Es imprescindible “ponerse en sus zapatos” y detectar cuáles son sus necesidades y de qué manera pueden ayudarles a ser más independientes.

En este caso, la aplicación que ha creado Google, llamada “Lookout”, está diseñada para personas invidentes o con una ceguera avanzada. La idea es que con la cámara de su móvil, puedan saber los principales objetos, lugares o textos más importantes que tienen delante de ellos. De tal manera que no haga falta que pregunten a nadie o tengan que usar las manos o el bastón para identificar un lugar. Es una herramienta más con la que poder ampliar su alcance de “visión” del espacio que les rodea.

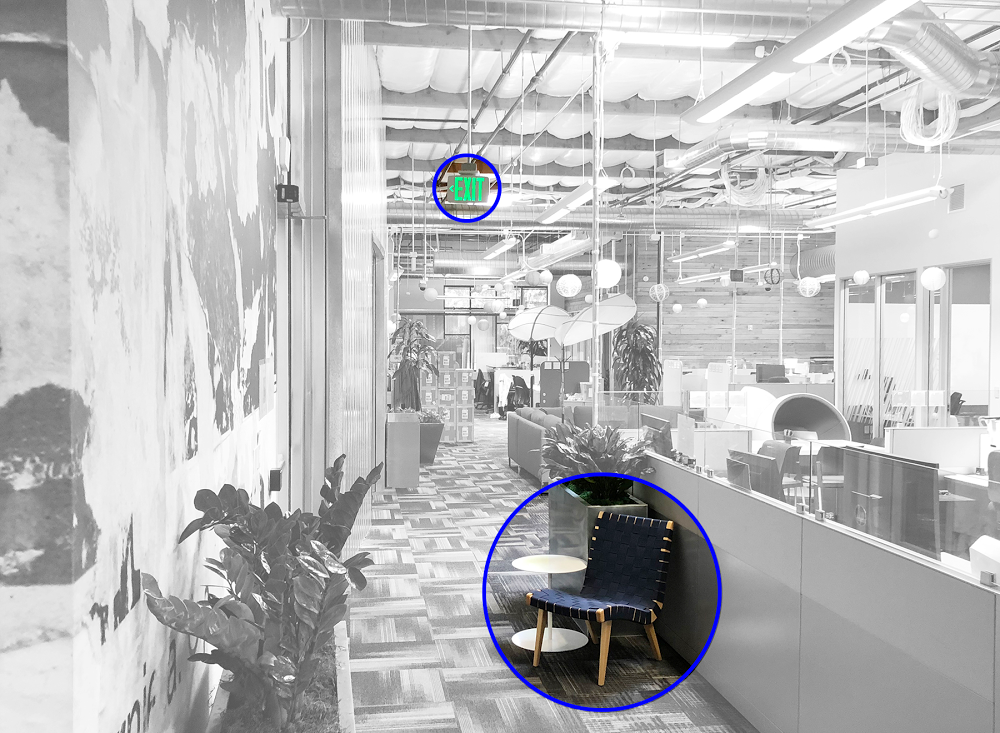

Según apunta Google, el funcionamiento es sencillo. Una vez que la aplicación está activada, la cámara del móvil debe apuntar hacia delante, de esta manera, será los ojos de la persona invidente. Por ello, es recomendable que lleve su móvil colgado del cuello o en un bolsillo delantero de la camisa, de tal forma que se puedan captar cuantas más imágenes, mejor. Es entonces cuando comienza la magia: la aplicación detecta la información relevante a su alrededor y se la transmite al usuario (una receta de cocina, dónde está el baño más cercano, la señal de salida o una silla para sentarse).

[youtube]https://www.youtube.com/watch?v=k1mz7b-A22c[/youtube]

Existen cuatro modos dependiendo de las necesidades básicas: Casa, Trabajo & Acción, Escaneo y Experimental. Dependiendo de la situación, el invidente elegirá qué es lo que necesita escuchar: si está en casa, por ejemplo, obtendrá notificaciones sobre dónde está el sofá, una mesa o el lavavajillas. Para guiarse, el móvil le dirá en qué posición está con frases como “a las tres en punto” (derecha), “a las 12 en punto” (de frente). La aplicación aprenderá con el usuario cada día hasta el punto de que podrá nombrar aquellos objetos con los que está más familiarizado el invidente y necesita tener siempre a mano.

[image id=»96239″ data-caption=»Credit: Google Blog» share=»true» expand=»true» size=»S»]Por otro lado, al igual que la aplicación que os presentábamos ayer, Google Lens, también puede hacer una captura de una imagen de algo que tiene delante y el móvil le dirá qué es. De esta manera también puede sentirse mucho más independiente en lugares poco comunes o a los que entra por primera vez.

La app estará disponible de momento en Estados Unidos y, poco a poco, estará en funcionamiento en el resto del mundo.

Alberto Pascual García